hadoop伪分布下 namenode或datanode无法启动解决

作者:Zhan-bin

日期:2018-6-26

解决过程

这里我安装的是ubantu16.04和hadoop2.9.1

有时候我们进行namenode格式化或者其他误操作之后会使namenode和datanode的clusterID不一样,这样的话就会造成这两个节点的其中一个无法启动。

这里仅是namenode和datenode 的clusterID不一样的情况下的解决办法。

进入到hadoop安装目录,这里我的安装目录是 /usr/local/hadoop 下面以这个做示例1

cd /usr/local/hadoop

如图:

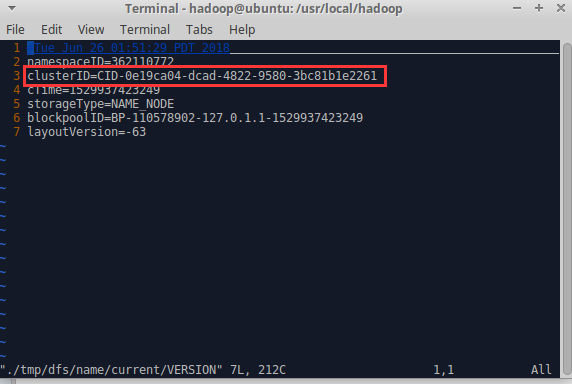

然后分别执行1

vi ./tmp/dfs/name/current/VERSION

1

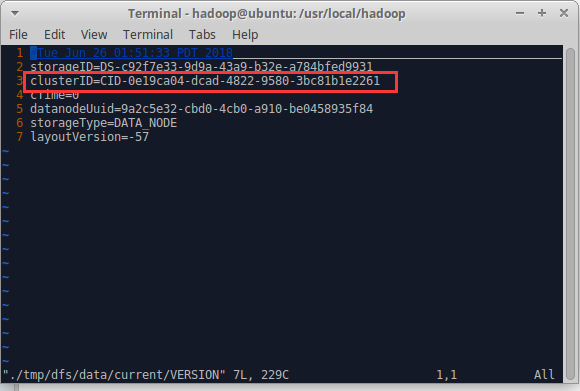

vi ./tmp/dfs/data/current/VERSION

对比两个节点的clusterID , 如果不一样则将Datanode的clusterID改为和Namenode的一样。

不会用vim的请参考:常用的vim操作命令

执行1

./sbin/stop-dfs.sh

关闭节点,在重新开启即可。1

./sbin/start-dfs.sh